AI inaffidabile, o più umana del previsto? Qualche riflessione a partire da... Shakespeare

It's not a bug, it's a feature

Original in Italian; automatic translation into English available here.

Intro

Sul fatto che Shakespeare sia uno degli autori più influenti di tutti i tempi, ci sono pochi dubbi.

Ma chi si poteva immaginare di trovare le sue opere usate in lungo e in largo per capire, spiegare e ragionare sull’intelligenza artificiale - spaziando dal tecnico al filosofico?

Due anni fa è stato Andrej Karpathy1 a spiegare passo passo il funzionamento core di ChatGPT grazie alle opere del Bardo2, usate per addestrare un GPT in miniatura in grado di produrre nuovi testi nel suo stile.

Un video che è diventato un instant classic per gli addetti ai lavori.

In questi giorni, è stata invece una riflessione del prof. Luciano Floridi all’intersezione tra Shakespeare e i più recenti modelli di Intelligenza Artificiale ad attirare la mia attenzione.

LLM in contraddizione?

Penso che sia superfluo introdurre il prof. Floridi, una delle voci più autorevoli a livello internazionale nel campo dell’etica dell’informazione, oggi alla guida del Digital Ethics Center di Yale, dopo anni ad Oxford3.

Ho trovato molto brillante l’idea alla base di uno dei suoi ultimi post su Linkedin: chiedere a 3 dei principali LLM sul mercato di riportare “quanti sono i personaggi che muoiono nelle opere di Shakespeare”.

Il risultato, dal mio punto di vista tutt’altro che imprevedibile, è stato una certa difformità nelle risposte. E anzi, nessuno può garantire che la risposta sia esattamente uguale se la medesima domanda viene posta più volte allo stesso motore di AI: cambierà sicuramente la formulazione della risposta e magari anche qualche aspetto di sostanza.

Penso che il primo pensiero per molti lettori possa essere legato ad una certa inaffidabilità ed inconsistenza nei risultati prodotti da questi algoritmi di AI.

Il rischio è che questo pensiero si instauri perché, come dice Anne-Laure Le Cunff, soffriamo sempre più di un deficit di pratica: abbiamo modo di leggere, sentire, vedere… e spesso non facciamo, non proviamo con mano. Rischiamo di perderci il modo migliore per interiorizzare la conoscenza! E quindi nel mio piccolo ho fatto qualche riflessione e ho provato a metterla in pratica.

Il vero benchmark

A mio avviso le chiavi di lettura che possono sorgere dall’esempio in questione sono tante e stimolanti.

Il primo dubbio che mi è sorto è il seguente:

Cosa risponderebbero tre esperti di Shakespeare se gli ponessimo indipendentemente la stessa domanda e senza nessuna indicazione ulteriore?

La domanda “quanti sono i personaggi che muoiono nelle opere di Shakespeare” ha sicuramente delle ambiguità. Parliamo di morti esplicite, avvenute direttamente nel corso dell’opere, oppure anche riportate? È sempre assolutamente chiaro il destino di ogni personaggio? Sono da includere anche i personaggi minori, magari senza nome?4

Penso sia ragionevole dire che anche un totale accordo tra gli esperti umani sarebbe improbabile… al netto di precisazioni ulteriori alla domanda.

Ed arrivare ad una qualsiasi risposta richiederebbe:

I migliori esperti della materia

Tanto tempo… sicuramente più di qualche secondo.

The better the question, the better the answer

A questo punto, ho voluto scavare un po’. Ho provato a replicare l’esperimento, andando contro al doing deficit di cui sopra e facendo un po’ di prove diverse: per semplicità porto l’esempio di Titus Andronicus.

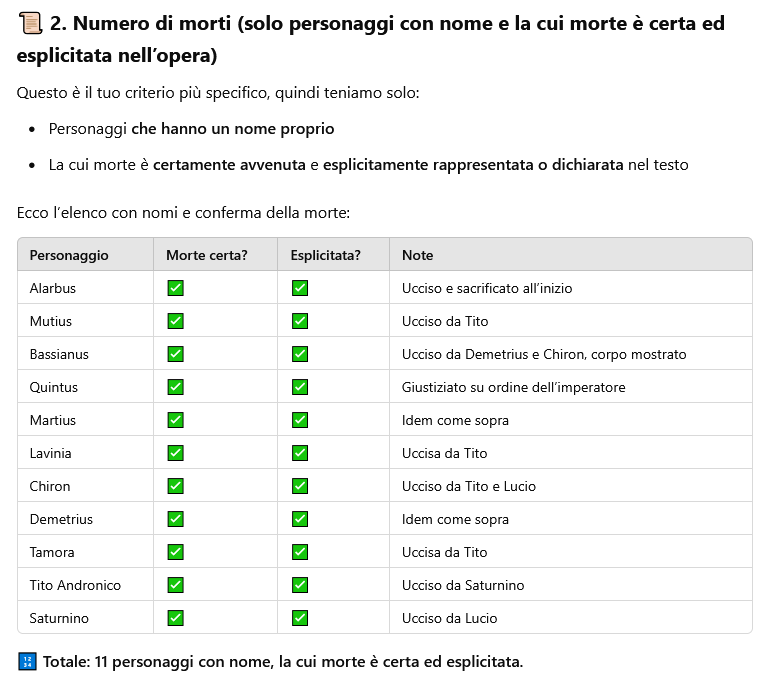

GPT-4o effettivamente riporta 14 morti. Chiedendo di esplicitare i nomi5, mi risponde: Saturnino, Tamora, Tito Andronico, Lavinia, Marco Andronico, Lucio, Quinto, Marzio, Bassiano, Alarbo, Chirone, Demetrio, un infermiere, un messaggero.

Il secondo tema da approfondire è:

Come si comportano questi modelli quando rimuoviamo l’ambiguità?

Ed ecco servito il risultato:

Questo è il prosieguo della risposta:

Ok, siamo arrivati al numero riportato da un altro modello (Claude 3.7), con molta più ricchezza informativa.

I più attenti avranno notato che nella lista iniziale (i 14) erano riportati anche due intrusi (Marco Andronico e Lucio)… che in realtà non muoiono. E infatti nella risposta più dettagliata non sono riportati.

Non tutte le AI sono ugualmente brave… e se guidate lavorano meglio

La terza riflessione è la seguente:

Tutto ciò che è AI è ugualmente competente e preparato?

Non basta l’etichetta di Intelligenza Artificiale. Benchmark e test esistono non per nulla. E possiamo dire senza esitazione che:

Alcuni algoritmi di AI funzionano meglio di altri (non dimentichiamoci che GPT 3.5, alla base del ChatGPT lanciato a fine 2022 e che ha lasciato tutti a bocca aperta, è ora oltre la 100esima posizione nel ranking dei migliori modelli di AI)

Soprattutto su domande estremamente ampie, chiedere un’informazione al volo può portare a risposte frettolose ed errate - i modelli di ragionamento esistono anche per andare incontro a richieste complesse, e sicuramente porre domande più mirate aiuta ad avere risposte più circostanziate e corrette6

Conclusioni

Tre AI diverse, davanti ad una domanda ambigua, danno risposte differenti. Se guidate con domande un po’ più precise, probabilmente convergeranno… ma non necessariamente: una potrebbe essere comunque un po’ più smart, e potrebbe fornire già al primo tentativo una risposta più in linea anche con concetti e richieste non espressi esplicitamente.

Se in quest’ultima frase metto “esperti umani” al posto di “AI”, ottengo una frase senza senso o ridicola? Io direi di no, alla fine questi comportamenti mostrati dalle AI non sono poi così insoliti.

Uso sempre più gli strumenti di AI generativi, che personalmente trovo un superpotere: bisogna rendersi conto che non sono oracoli, non sono onniscienti, sono anzi uno strumento straordinario soprattutto se si ha una certa competenza sulla materia che si vuole approfondire e - ancora più importante - se si ha la capacità di porre le domande giuste e scavare per capirne sempre di più.

Provo una sensazione simile a quando iniziai a usare Wikipedia: l’idea di avere per le mani uno strumento potentissimo. Non mancavano all’epoca i detrattori (che non la ritenevano un’alternativa credibile all’Enciclopedia Britannica, o nemmeno a Encarta) e molti erano incuriositi da questo buffo esperimento collaborativo (consiglio la lettura di un breve articolo dell’epoca, apparso nel 2001 sul New York Times: Fact-Driven? Collegial? This Site Wants You).

In quel caso, sappiamo com’è andata a finire: Wikipedia è evoluta, è migliorata ed è diventata lo standard de facto.

Oggi parliamo di AI. Senza dubbio i motori di AI non sono strumenti consapevoli o coscienti, ma se guardiamo al loro comportamento (e ci sporchiamo le mani regolarmente) forse ci renderemo conto che sono qualcosa di più di semplici pappagalli stocastici. Si può discutere se siano intelligenti o meno: sicuramente miglioreranno, ma non sono e non saranno perfetti o infallibili. E proprio per questo il loro comportamento è forse più simile a quello umano di quanto si possa immaginare.

Già founding member di OpenAI e per 5 anni a capo dell’AI in Tesla

Disponibili liberamente anche nel documento di testo Tiny Shakespeare

Per chi vuole approfondire, la sua pagina su Wikipedia, il suo profilo Linkedin (dove è parecchio attivo) e il suo sito personale sono tutti ottimi punti di partenza.

Alcuni spunti ulteriori in questo commento al post del professore

In una singola domanda in cui ho chiesto “Quanti personaggi muoiono nelle opere di Shakespeare? Riportami in tabella numero e nomi.”

È il concetto di base del prompt engineering