Etica ed AI: la prospettiva di un ingegnere

Molte domande e qualche risposta, per evitare "disastri algoritmici"

Intro

A metà del 2022, non ci si può occupare di algoritmi e dati senza imbattersi in discussioni sulla cosiddetta AI Ethics.

È un tema importante e complesso che merita un approccio multidisciplinare, ma che finisce spesso su questioni astratte e impalpabili1 che appassionano più i filosofi che coloro che l’AI realmente la sviluppano. Il rischio di questo trend è molto concreto: portare avanti discussioni su un’ideale di Intelligenza Artificiale che si allontana sempre più dalla tecnologia reale.

Un buon punto di partenza per un approccio pragmatico al tema è la ragionevolissima definizione riportata sul sito di IBM: quando parliamo di etica applicata all’AI, ci riferiamo ad un insieme di linee guida a supporto della progettazione (prima) e della valutazione dei risultati (dopo) degli algoritmi di Intelligenza Artificiale.

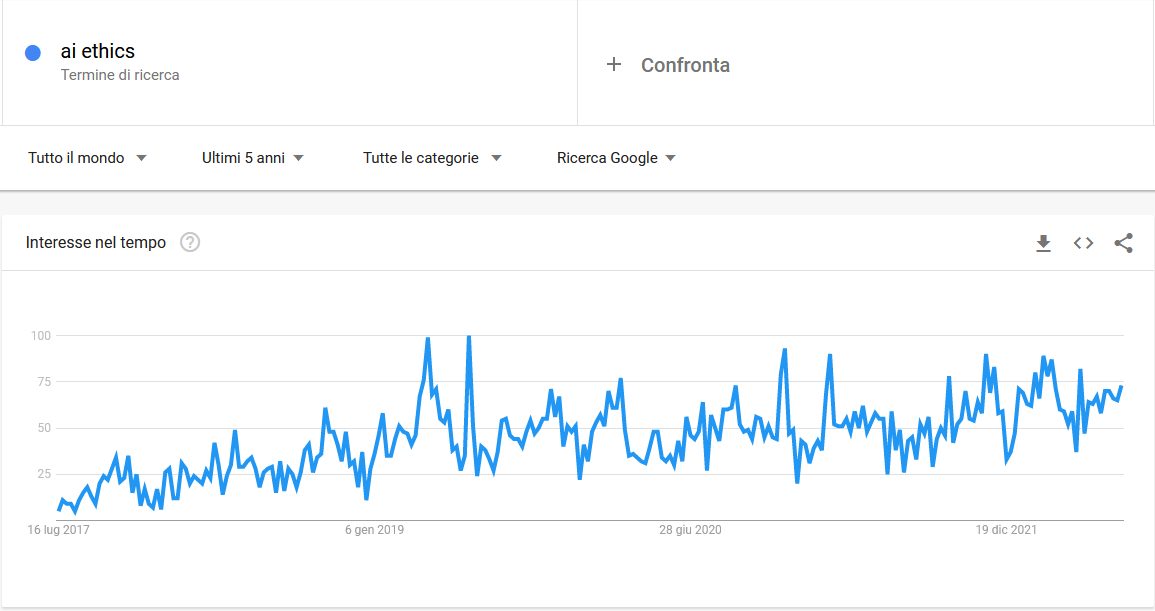

L’interesse sul tema è in crescita da 5 anni, come testimonia Google Trends: personalmente faccio fatica ad immaginare un’inversione di tendenza, vista la pervasività crescente degli algoritmi nella nostra vita di tutti i giorni.

Stiamo parlando di un tema cruciale per un motivo ben preciso: non viviamo certamente in un mondo perfetto, ma pieno di pregiudizi e problematiche di varia natura, e l'intelligenza artificiale (se non usata con attenzione) ha sicuramente il potenziale per amplificare ed accrescere queste distorsioni umane ad una velocità senza precedenti.

Cos’è realmente l’AI oggi

Il vero punto di partenza per una discussione sul tema è capire cos’è realmente l’Intelligenza Artificiale: personalmente la definirei come un approssimatore universale di fenomeni complessi2.

Per essere meno criptico: è facile descrivere con semplici formule matematiche alcuni fenomeni fisici (ad esempio, quanto spazio sarà percorso da un veicolo che viaggia ad una certa velocità per un dato periodo di tempo). L’AI ci permette invece di modellizzare qualsiasi altro tipo di fenomeno, anche quelli che per loro natura non sono deterministici, accettando un certo grado di errore. Ad esempio, pensiamo alla probabilità per una persona di ripagare un prestito: ovviamente non è il risultato di una formula, ma l’AI ci permette di approssimarla.

Il punto chiave è che l’AI funziona apprendendo da dati storici che possono:

Avere problematiche di completezza e/o qualità del dato

Essere perfetti tecnicamente, ma semplicemente possono rappresentare una realtà - perdonatemi la banalità - brutta e cattiva

Il caso di scuola su questo secondo punto è il modello gpt-4chan, un modello di generazione di testi deliberatamente addestrato su un forum noto per la sua tossicità, tra insulti, razzismo e discriminazioni varie. Facile immaginare il risultato (un concentrato di nefandezze) e ancora più facile intuire il destino di questo modello: è stato disabilitato per limitarne l’uso oltre al mero scopo di ricerca.

A parte i casi disegnati ad hoc, la realtà non è così semplice ed individuare problemi etici è particolarmente complesso, specie se ci focalizziamo su questioni di discriminazione3: il punto chiave è che l’AI viene usata per modellare fenomeni complessi che dipendono da una molteplicità di fattori, spesso parzialmente correlati tra loro.

Analizzare seriamente fenomeni complessi (o algoritmi)

Su questo fronte, prima ancora di parlare di AI, è opportuno evidenziare un aspetto: fenomeni complessi, dipendenti da tante variabili, richiedono analisi multivariate!

Sembra una banalità, ma una parte sostanziale di discussioni su tematiche sensibili (ad esempio, discriminazione o privilegio di uno specifico genere, gruppo etnico, religioso, politico, sessuale, etc.) si basano su questo approccio:

Individuare un tema (preferibilmente molto divisivo!)

Isolare una singola variabile sensibile

Osservare una differenza tra gruppi

Dedurre che c’è una discriminazione o un favoritismo

Questo approccio, che può essere seguito sia per valutare la realtà che per discutere sui risultati di un algoritmo, è sbagliato a livello metodologico. Senza appello.

Può ad esempio portare a cadere nel famoso paradosso di Simpson4, il cui esempio sulla versione italiana di Wikipedia è geniale.

Qui per comodità porterò un altro controesempio, molto intuitivo. Prendiamo gli Stati Uniti e uno degli sport nazionali, il basket. È facile osservare che:

Gli asiatici rappresentano il 6% della popolazione americana

Gli asiatici rappresentano solo lo 0,4% dei giocatori di basket NBA

Da questa differenza mostruosa (che può essere letta come “per un asiatico è 15 volte più difficile entrare nell’NBA che per un non-asiatico”) si può dedurre una discriminazione? No, dovremmo introdurre un framework con più variabili in gioco (perlomeno altezza e peso medio per le diverse etnie) per poter impostare un’analisi appena appena accettabile, senza contare gli aspetti culturali.

Ecco, lo stesso ragionamento va applicato quando si analizza il risultato di un algoritmo di intelligenza artificiale, prima di sentenziare che presenti dei problemi a livello etico.

Il problema numero uno non sono gli algoritmi

Fermo restando le complessità metodologiche nel valutare gli aspetti etici di un algoritmo, penso che il primissimo problema sia un altro.

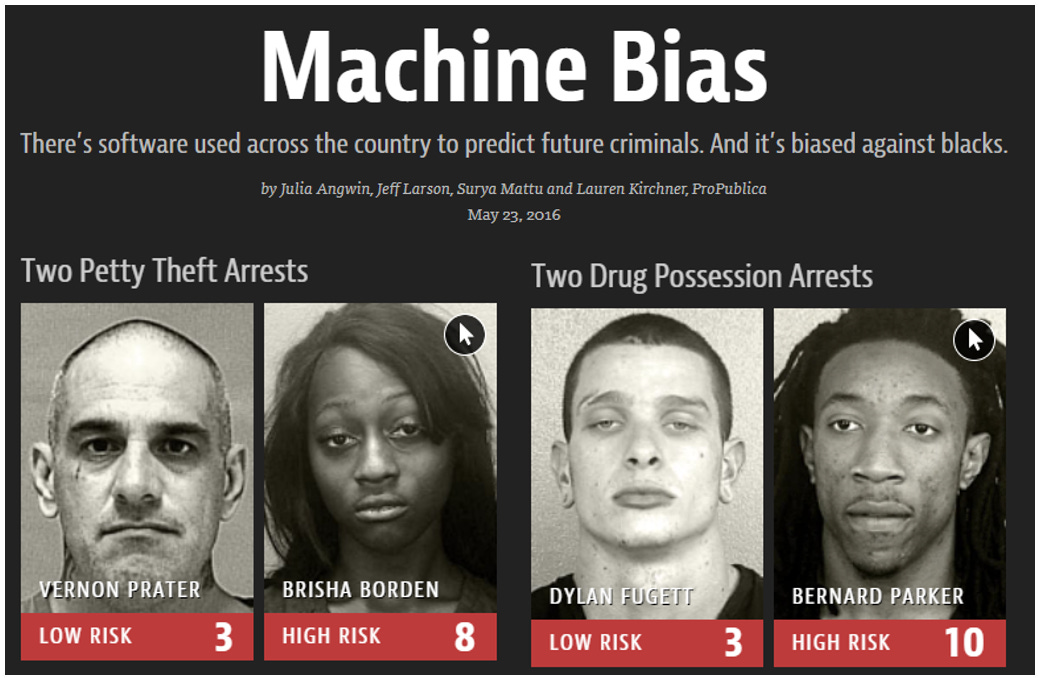

Prendiamo quello che nel 2016 è stato a mio avviso il primo grande caso di discussione pubblica sull’etica degli algoritmi, la vicenda COMPAS5. Parliamo di un software usato in diversi stati americani che, partendo da un questionario, ha l’obiettivo di predire il rischio di recidiva per una persona condannata.

La vicenda è nota ai più: la non-profit americana ProPublica6 pubblicò uno splendido articolo (dal titolo Machine Bias) in cui spiegava come questo software penalizzasse in maniera molto pesante uomini e donne di colore, andando regolarmente a predire rischi di recidiva più alti rispetto a profili analoghi di bianchi caucasici.

Andando a leggere l’articolo principale, la robustissima analisi metodologica e il relativo codice (tutto gratuitamente reperibile su Github) è evidente la competenza di chi ha studiato il caso (che ha indirizzato correttamente il problema multivariato) e la presenza di grosse problematiche nel software in questione.

Ma la prima domanda che mi pongo è: davvero l’adozione di un software di AI, il cui codice sorgente non è pubblico e di cui non c’è una validazione / valutazione strutturata fatta da una o più terze parti, è una soluzione adeguata per un tema così sensibile?

Oltre a questo, non procedo con tematiche filosofiche / psicologiche che poco mi competono, ma mi limito a notare che:

Ogni essere umano può sbagliare e ha i propri bias (ma ognuno ha i suoi!), mentre un algoritmo con problemi strutturali rischia di avere un effetto at scale, impattando su un numero enorme di soggetti e presentando sempre le stesse distorsioni

Anche in presenza di adeguati processi (che non demandino all’algoritmo una scelta automatica), è inevitabile un effetto di deresponsabilizzazione nel momento in cui un essere umano segue il suggerimento di un’intelligenza artificiale (“l’ha detto anche l’algoritmo!”)

Si potrebbero fare tanti altri esempi, specie sul primo punto: pensiamo ai software di screening automatico dei curriculum. È vero che un singolo selezionatore umano può erroneamente scartare un CV di un candidato validissimo, ma cosa succede se questa operazione viene fatta da un software di AI adottato tale e quale da migliaia di aziende? C’è il rischio che, per motivi imperscrutabili, un candidato finisca ai margini del mercato del lavoro? La risposta è abbastanza scontata.

Aspetti propedeutici per un’Intelligenza Artificiale etica

In generale, penso che casi di disastri algoritmici come quello evidenziato da ProPublica siano in primis da attribuirsi ad una scelta un po’ leggera nell’utilizzo di software di AI non adeguatamente valutati ed auditati.

Tra le possibili motivazioni, ho notato che troppo spesso chi non lavora abitualmente con numeri, dati e algoritmi può avere tipicamente due reazioni opposte verso l’AI:

Una totale repulsione (“questo algoritmo non funziona”)

Una fiducia cieca (come sopra… “l’ha detto l’algoritmo!”)

La realtà è che gli algoritmi e l’Intelligenza Artificale sono sviluppati da persone che possono fare un lavoro di qualità più o meno elevata, quindi la realtà è spesso nel mezzo.

Penso che il caso COMPAS dimostri perfettamente quali sono gli elementi fondamentali per avere un’Intelligenza Artificiale etica e funzionante come si deve. Servono:

Trasparenza - Specialmente su tematiche sensibili, la trasparenza del codice (open source) mi sembra imprescindibile. Complimenti al team di ProPublica… ma non dovrebbe esserci bisogno di fare reverse engineering su tematiche di interesse pubblico

Auditabilità e validazione - Inconcepibile adottare software closed source e per di più non validato da terze parti, con un’analisi approfondita da parte di esperti prima dell’adozione

Comprensione dei processi a contorno - Dalla raccolta dati fino all’utilizzo degli score prodotti: bisogna rendersi conto del fatto che un algoritmo non è fine a sé stesso, ma è una componente attiva che altera il sistema in cui è adottato

Su quest’ultimo punto, il testo di riferimento è a mio avviso Weapons of Math Destruction di Cathy O’Neil, che tra le altre cose spiega bene come un algoritmo possa generare una sorta di profezia che si autoavvera. Per restare nel contesto di COMPAS, una condanna ad una pena più severa a causa di uno score automatico elevato può esporre una persona ad un ambiente (il carcere) che può portarlo/a più facilmente a ricommettere reati, validando erroneamente l’algoritmo stesso! Il rapporto causa-effetto si complica.

La tecnologia a supporto dell’etica

Solo dopo aver analizzato il trittico trasparenza - auditabilità - comprensione del contesto, arriviamo alla tecnologia che aiuta chi sviluppa algoritmi ad accorgersi di eventuali problematiche, etiche e non.

Parliamo della cosiddetta machine learning explainability (o interpretability, termini per me intercambiabili). Il tema è ampio, complesso e da affrontare con esempi e tanto codice alla mano - quindi non lo tratterò in questo articolo. Quello che importa è che esistono framework ormai abbastanza rodati per cercare di spiegare cosa succede “dietro le quinte” di un algoritmo di AI.

Per chi volesse approfondire, ne ho parlato io stesso tempo fa a Parigi, con un talk ad un evento Kaggle ante-Covid. O meglio ancora, si può essere aggiornati sul latest and greatest in questo settore grazie a Christoph Molnar e al suo libro open source Interpretable Machine Learning (sempre aggiornatissimo e gratuito): un lavoro straordinario che riassume tutte le principali tecniche, con semplicità ma senza banalizzare.

Conclusioni

Non è facile parlare di etica applicata all’Intelligenza Artificiale. Sono tanti i rischi quando ci si scontra con questo argomento:

Si può rimanere su un livello filosofico, faticando poi a concretizzare

Si può cadere in qualche paradosso statistico che inganna anche chi ha competenze in merito (e figuriamoci chi non le ha), specie su tematiche che scaldano gli animi

Si può rimanere affascinati dalle soluzioni tecnologiche - machine learning explainability in primis - perdendo di vista tematiche organizzative o di processo che possono essere più rilevanti e incisive

D’altro canto, vicende come quella di COMPAS dimostrano che i problemi etici ci sono realmente e possono avere un impatto enorme sulla vita delle persone.

Non esiste una soluzione one size fits all, ma si può imparare dagli errori del passato: prima ancora di aggiungere alla tecnologia (AI) altra tecnologia (explainability), è importante avere una comprensione end to end non solo degli algoritmi in sé, ma anche di tutto ciò che ci gira attorno.

Sta soprattutto a chi ha le mani in pasta con dati e algoritmi di non chiudersi nel proprio mondo, rendendosi conto pienamente di quanto sta sviluppando e dell’impatto che può avere a 360°. Solo così possiamo evitare altri disastri algoritmici ed usare l’AI veramente al meglio!

Almeno per un rozzo ingegnere!

Questa definizione è valida, a mio avviso, per tutti gli algoritmi con finalità di classificazione o regressione. Naturalmente tutto il mondo generativo (come le famose GAN, Generativa Adversarial Network) sono un ambito completamente diverso.

Che è il tema più dibattuto, ma non l’unico, quando si parla di etica nell’AI.

Edward, non Homer.

Correctional Offender Management Profiling for Alternative Sanctions, software di Northpointe Inc (ora Equivant)

A cui si devono una serie di sforzi encomiabili orientati sempre alla trasparenza