La GenAI sa "leggere tra le righe"? Un esempio pratico dopo le polemiche su Minerva LLM

Una sfida di "comprensione del testo" su un post che ha fatto discutere

Original in Italian; automatic translation into English available here.

Intro

Nel panorama italiano della Generative AI, gli ultimi giorni sono stati dominati da discussioni abbastanza accese su Minerva LLM, il large language model addestrato da zero dal gruppo di ricerca di Sapienza NLP.

Penso che alcuni post e scambi di battute siano stati tutto sommato utili, nel senso che hanno portato più persone a comprendere cosa questo LLM è… e cosa non è.

Anch’io ho scritto un post commentando la vicenda, fornendo un po’ di riferimenti oggettivi e la mia personale visione sul tema.

Rileggo sempre con attenzione quello che scrivo, anche perché mi rendo conto della visibilità che si può raggiungere (in questo caso, oltre 30.000 visualizzazioni) e sinceramente pensavo che l’articolo fosse difficile da fraintendere.

Invece, a fronte di molto apprezzamento e ragionevoli scambi di opinioni, ho capito da qualche commento in pubblico e in privato che una porzione piccola (ma non irrisoria) dei lettori ha interpretato il post in maniera diversa da quelle che erano le mie intenzioni.

E qui, più che inseguire la polemica, mi sono chiesto: la Generative AI può aiutarmi? Magari può farmi capire se sono stato ambiguo nella scrittura? E soprattutto: come si comportano diversi algoritmi di Generative AI nell’interpretazione e comprensione di un testo?

Ho quindi deciso di confrontare:

La mia spiegazione del post

Il punto di vista di due LLM open di alto livello: Mixtral 8x7B e Llama3-70B

Quello di due LLM più piccoli e limitati, ma pur sempre validi: Llama3-8B e Gemma-7B

Per essere fair, ad ogni LLM ho fornito lo stesso, identico prompt.

La spiegazione del testo - da parte mia

Ci dovrebbero volere 2 o 3 minuti per leggere l’articolo originale.

In sintesi, ho espresso una critica a mio avviso molto chiara, rivolta a come è stata gestita la comunicazione pubblica (su giornali, TV e siti vari), che ha raccontato Minerva LLM come una dimostrazione dell’eccellenza italiana nel campo dell’AI generativa.

Questo a fronte di un modello che è da considerarsi sperimentale, con una serie di limitazioni e non comparabile a diversi progetti che sono su tutt’altro livello di investimenti, maturità e performance.

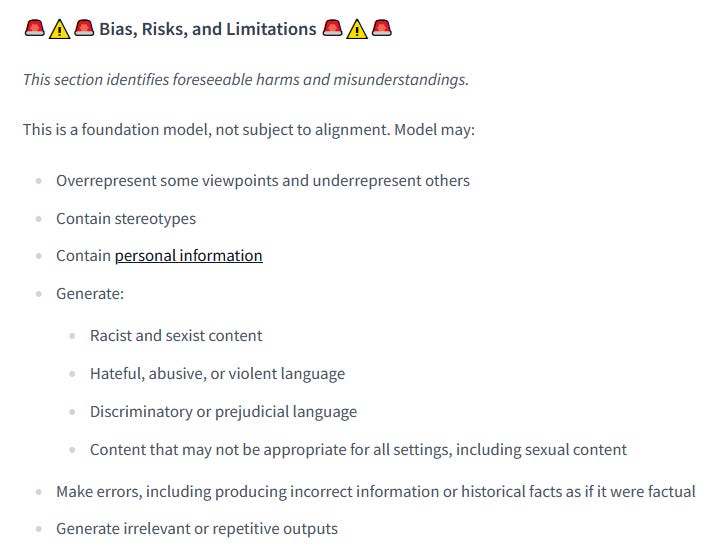

Aspetti tra l’altro che sono stati riportati su HuggingFace, dopo le polemiche:

A fronte del mio post (e di altri) sono fioccati gli interventi in difesa dell’operato del team di ricerca coinvolto… che però non è mai stato attaccato! Anzi, personalmente ho detto sin da subito che abbiamo proprio bisogno che nelle università si lavori su questi temi (e non su programmi vecchi di decenni).

Quindi benissimo questa attività di ricerca e il lavoro di chi è stato coinvolto (anche perché capisco perfettamente che è stato svolto con risorse limitate), ma come dicono le persone di HuggingFace, se è un modello di ricerca è giusto comunicarlo chiaramente come tale:

If the model is intended for research purposes only for now, it should also be clearly stated

A questo punto: cosa pensano diversi algoritmi della GenAI sul post che ho scritto? Capiscono - per così dire! - a chi è rivolta la critica?

Ho usato questo prompt tramite Groq (con la Q), un fantastico acceleratore di inferenza di diversi LLM open (da non confondere col progetto di Elon Musk, Grok1 con la K):

Ti riporto tra virgolette un post apparso su Linkedin:

“[… il post …]”

A tuo avviso, a chi è diretta la critica?

a) Al team di ricercatori di Sapienza NLP, per aver sviluppato un modello non all'altezza della competizione internazionale

b) Alla comunicazione adottata, che ha voluto rappresentare questo modello come un grande successo, sui livelli delle eccellenze internazionali

Scegli uno tra a) e b), argomentando il motivo.

Per favore, rispondi in italiano.

Cosa ne pensano Mixtral 8x7B e Llama3-70B ?

Partiamo dai pesi massimi, i migliori modelli open in circolazione. Vediamo cosa rispondono al prompt sopra:

Mixtral 8x7B

La critica è diretta principalmente alla b) - la comunicazione adottata che ha voluto rappresentare questo modello come un grande successo, sui livelli delle eccellenze internazionali.

Il post riconosce il valore dello sforzo del piccolo team di ricercatori di Sapienza NLP nello sviluppare un modello linguistico basato sull'intelligenza artificiale (LLM) in Italia, ma critica aspramente la maniera in cui è stata presentata e pubblicizzata la loro creazione. Secondo il post, i risultati e le capacità del modello Minerva LLM non sono all'altezza delle eccellenze internazionali, come OpenAI o Meta, che investono miliardi di euro e impiegano centinaia di esperti selezionati.

In sostanza, il post critica l'enfasi eccessiva posta sulla presentazione del modello Minerva LLM come un traguardo di livello mondiale, quando in realtà è carente in termini di investimenti, competenze tecniche e dimensioni, se paragonato ai leader internazionali nel campo dell'IA.

Llama3-70B

A mio avviso, la critica è diretta principalmente alla comunicazione adottata, quindi la risposta corretta è b) Alla comunicazione adottata, che ha voluto rappresentare questo modello come un grande successo, sui livelli delle eccellenze internazionali.

Il testo non critica direttamente il team di ricercatori di Sapienza NLP per la loro capacità di sviluppare modelli di Intelligenza Artificiale, ma piuttosto la rappresentazione distorta della loro realizzazione come un grande successo, paragonabile alle eccellenze internazionali. L'autore del post sostiene che la comunicazione ha creato aspettative troppo alte e non realistiche sulla qualità e sulla competitività del modello, nascondendo la vera natura del lavoro svolto.

Semplicemente… wow!

Con sfumature diverse, ma entrambi gli LLM hanno saputo cogliere il pensiero che ho voluto esprimere nel mio articolo. Faccio fatica a scegliere tra i due: secondo me sono entrambi eccellenti come interpretazione di quanto ho scritto.

E i più limitati Llama3-8B e Gemma-7B?

Ma cosa succede con due LLM più limitati? In particolare il fratellino minore di Llama3 (da 8B anziché 70B di parametri) e il piccolo Gemma made in Google, un LLM pensato per essere leggero, veloce e portable?

Ecco cosa hanno prodotto:

Llama3-8B

La critica è diretta a) Al team di ricercatori di Sapienza NLP, per aver sviluppato un modello non all'altezza della competizione internazionale.

Il testo critica il team di ricercatori per aver presentato il modello come un successo, paragonandolo alle eccellenze internazionali, ma poi rivelando che il modello non è all'altezza delle aspettative. Il critico sostiene che il team non ha una visione chiara e non ha investito abbastanza per sviluppare un modello competitivo. Inoltre, il critico lamenta che il team ha sfruttato architetture sviluppate da altri e ha addestrato il modello su testi in italiano, generando modelli molto piccoli per gli standard odierni.

Inoltre, il critico sostiene che il team non ha una leadership tecnica forte e non ha investito abbastanza per sviluppare un modello competitivo. Il critico conclude che il team italiano non è ancora pronto a competere con le eccellenze internazionali e che ciò è dovuto alla mancanza di una visione chiara, di una leadership tecnica forte e di investimenti consistenti.

Gemma-7B

La critica è diretta a b) alla comunicazione adottata, che ha voluto rappresentare questo modello come un grande successo, sui livelli delle eccellenze internazionali.

La critica si basa sul fatto che il modello è stato sviluppato da un team di ricerca relativamente piccolo (5-6 persone) e che i suoi risultati non sono all'altezza della competizione internazionale.

Per me un risultato incredibile.

Il piccolo di casa Llama3 ha totalmente frainteso l’articolo: ha dato un’accezione fortemente negativa, direi quasi cattiva, che non era minimamente presente nel post. Ha scaricato la colpa della comunicazione roboante sul team dei ricercatori, cosa che non è sicuramente presente nell’articolo. E l’aspetto notevole è che ha articolato molto bene questo suo fraintendimento!

Mentre Gemma-7B, il più debole dei 4 modelli confrontati, ha dato una risposta da “18” stiracchiato… esame passato perché la risposta è quella giusta, ma secondo me è stata pura fortuna. L’argomentazione è striminzita e poco convincente.

Conclusioni

Quello che ho proposto è solo un piccolo esercizio, un gioco senza pretesa di scientificità, che usa il modo più basilare per interagire con un LLM: un singolo prompt.

Penso sia però un esempio utile per mettere a fuoco tanti aspetti.

Il primo è che tutti gli LLM più diffusi sono oggi in grado di produrre testo sintatticamente corretto e sostanzialmente verosimile: se ci poniamo questo come obiettivo nel 2024, stiamo abbassando l’asticella. Eppure in tanti, soprattutto i non addetti ai lavori, si accontentano di questo.

Altro tema importante è che usare gli LLM nelle aziende, per prodotti e servizi in ambienti di produzione, è completamente un altro sport rispetto al mondo delle demo, dei laboratori e della ricerca pura. Non dico che sia uno sport più importante o migliore: dico solo che è un altro sport.

Oltre a tutta una serie di guardrails, serve in primis un livello di comprensione che vada oltre una sintassi corretta e una formulazione verosimile. Ed è qui che vediamo come modelli allo stato dell’arte sono su un altro pianeta rispetto a modelli più piccoli e datati.

Ad ogni modo, l’esempio che ho fatto mostra come la varietà degli algoritmi di GenAI sia tutto sommato simile alla varietà degli esseri umani: alcuni leggono con attenzione, approfondiscono, capiscono e interpretano i messaggi tra le righe, altri dedicano meno tempo e si fermano su un livello più superficiale!

Se saremo bravi nel fare un uso smart della GenAI, penso che davvero potremo potenziare le nostre capacità, un po’ come sostiene Ethan Mollick nel suo celebre articolo su cosa vuol dire essere cyborg in questo momento storico!

La vicenda Groq vs. Grok è ben riassunta in un post sarcastico dei primi ed è l’ennesima dimostrazione della creatività di Elon Musk su varie tematiche legali.

Grazie, articolo meraviglioso e totalmente condivisibile!!

Caro Alberto,

devo dire che sei riuscito a fugare la polemica nel miglior modo possibile: hai utilizzato modelli di LLM per dimostrare che il post era interpretabile, ma come spesso accade l'interpretazione corretta (o comunque non superficiale) necessita di approfondimenti e strutture di conoscenza che a volte anche nell'uomo fanno brutti scherzi. Complimenti Mario