Delegare l'intelligenza (umana): il vero rischio dell'AI

Una preoccupazione a breve termine supportata da vari studi

Original in Italian; automatic translation into English available here.

Intro

Da 2001: Odissea nello Spazio a Blade Runner, da Terminator a Matrix: se Hollywood ci ha insegnato qualcosa sull’Intelligenza Artificiale, è che non possiamo trascurare il concetto di rischio.

E stando a queste autorevolissime fonti, al netto di qualche variazione sul tema, il pericolo è sempre uno e ben definito: una qualche rivolta delle macchine intelligenti, un loro tentativo di avere la meglio sul genere umano.

Questo tema affascina molti e le opinioni sono le più disparate, anche da parte di esperti o comunque persone ampiamente coinvolte sul tema.

Basti pensare alle due voci più distanti nel mondo dell’AI (Elon Musk e Yann Lecun), con il primo convinto che ci sia un rischio del 10-20% che l’AI prenda una direzione ostile (e comunque, molto esplicito sul fatto che l’AI si prenderà tutti i nostri lavori), ed il secondo per definizione1 sostenitore delle tesi contrarie.

Difficile per me prendere una posizione assoluta su questi scenari distopici, ma mi sembra che ci sia una fallacia di fondo: ci stiamo concentrando sull’evoluzione dell’AI e sulla sua crescita, diretta verso una sorta di superintelligenza in grado di sovrastare quella umana… ma è l’unico modo in cui le cose possono andare male?

Forse dovremmo vedere come se la passa l’intelligenza, quella umana, che ad oggi (e almeno per il futuro prossimo) è un elemento cardine per le decisioni che determinano l’evoluzione della nostra società.

Spesso la trattiamo come qualcosa di astratto e come una costante immutabile, eppure è evidente che così non è.

La conservazione della complessità

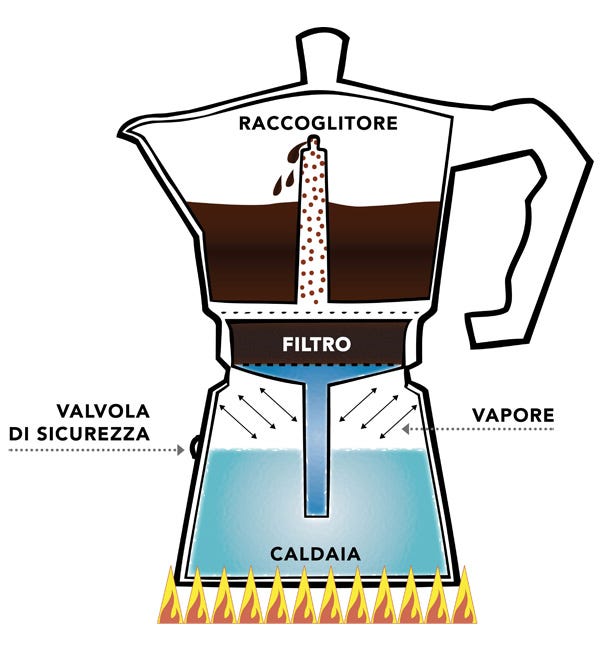

Nel primo articolo di quest’anno ho parlato di complessità ed in particolare della sua conservazione, con l’esempio del caffé.

L’idea di base è che la complessità di un determinato processo (come “fare il caffé”) è costante:

se uso una moka, la macchina è semplice, ma la complessità è spostata verso l’utente, che deve riempire la caldaia (ma non troppo), magari macinare il caffé, riempire il filtro, stare attento a quando esce il caffé…

se uso una macchina a capsule, l’utente deve solo inserire la capsula e schiacciare un bottone, ma il processo non si è semplificato: la complessità è ora nella macchina stessa e nella produzione delle capsule

Ecco, spostandoci gradualmente verso il mondo della tecnologia, possiamo facilmente pensare a tanti casi in cui le macchine hanno aiutato processi che coinvolgono le nostre funzioni cognitive, gestendone una parte della complessità.

Quanti di noi sanno fare velocemente una divisione con numeri ragionevolmente grandi, usando solo carta e penna (e senza metterci una vita)? L’introduzione della calcolatrice ha sicuramente ridotto lo sforzo cognitivo che dobbiamo fare per varie operazioni, trasformandolo nella semplice pressione di qualche tasto2.

Fino a qui tutto (abbastanza) bene: abbiamo ridotto il nostro impegno su operazioni che non richiedono spirito critico, liberando anzi la possibilità di focalizzarci su tematiche più stimolanti.

E negli ultimi decenni, l’evoluzione informatica ci ha permesso di lavorare su quelli che da ingegnere chiamerei livelli di astrazione sempre più alti. In altri termini, il software ha semplificato la vita non solo a chi vuol fare calcoli matematici, ma anche a chi vuole realizzare processi molto più complessi.

Metabolizzare le informazioni

Da decenni la tecnologia ha aiutato operazioni ripetitive (dai calcoli, alla raccolta, conservazione e processamento di dati), oppure ha facilitato l’accesso all’informazione (con Internet e la diffusione del sapere libero).

Ma quello che sta succedendo negli ultimi due anni con la larga diffusione dell’AI generativa è qualcosa di molto diverso.

Stiamo delegando all’AI sempre più operazioni che richiedono senso critico, capacità di discernimento, creatività… in altre parole, stiamo delegando una parte della nostra intelligenza, nel senso più ampio.

Pensiamo all’evoluzione nel modo in cui acquisiamo informazioni.

Nel mondo pre-Internet domestico, e francamente anche nell’epoca del lentissimo 56k (che ho vissuto pienamente), l’accesso alle informazioni era difficile e analogico. Ho un ricordo del concetto di ricerche fatte da bambino sui temi più disparati, a partire da libri cartacei, enciclopedie e affini: un’operazione non semplice e non veloce.

Poi è arrivata l’ADSL e la fibra, assieme a Wikipedia e al web 2.0: si è moltiplicata la quantità di dati a disposizione e si è ridotto il tempo per accedervi. Una cosa però non è cambiata: la necessità di tempo e capacità per metabolizzare queste informazioni e per sintetizzare nuova conoscenza, collegando i puntini di singole fonti e singoli argomenti.

Anzi, le nostre capacità cognitive sono state messe a più dura prova, vista la mole crescente di informazioni da processare e la possibilità di carotaggi pressoché infiniti.

Oggi invece la situazione è diversa.

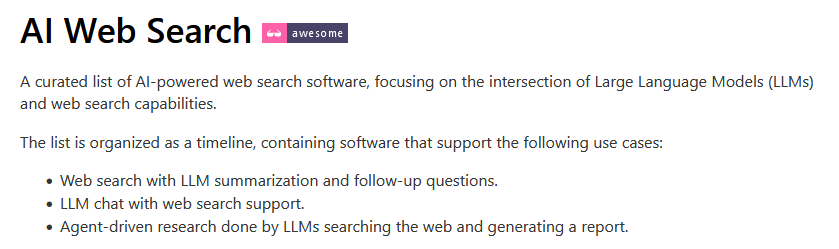

È facile tenere d’occhio l’evoluzione dei motori di ricerca, una pletora di soluzioni che vanno in una direzione molto chiara: pre-digerire i contenuti informativi per fornire una sorta di omogeneizzato. Dimentichiamoci Google e la necessità di aprire N link per farsi una propria idea su un tema.

La direzione è opposta rispetto a quella dei primi 20 anni del secolo. La complessità di acquisire informazioni e conoscenza è sempre la stessa: ma stiamo spostando sempre più questa complessità verso l’AI. Solo che questa volta non parliamo di delegare operazioni ripetitive e meccaniche.

Mi sembra che l’AI, più che diventare ostile, rischi di privarci di quell’allenamento cognitivo che è fondamentale per sviluppare senso critico e pensiero creativo. O meglio: siamo noi stessi, in maniera più o meno deliberata, a impigrirci grazie all’AI.

Forse non ce ne rendiamo conto, ma è già realtà

Lo spunto per questo articolo mi è venuto da alcune letture, tra cui quella di alcuni dati di un programma americano che va sotto il nome di NAEP long-term trend (LTT): un test standard per misurare in maniera quantitativa le capacità linguistiche e matematiche, sottoposto a poco meno di 10.000 studenti scelti in modo rappresentativo della popolazione.

Questi dati ovviamente non possono ancora risentire degli impatti della larga diffusione dell’AI, per motivi cronologici.

Ma fanno riflettere e mostrano un quadro già presente di declino nelle capacità dei preadolescenti statunitensi. Nulla di nuovo, a onor del vero, e anzi pienamente in linea con quanto suggerito da altri studi. Va da sé che l’impatto di minori capacità logiche nella popolazione potrebbe non essere dei migliori sulla società nel suo insieme.

Penso che sarà sempre più cruciale monitorare questi trend e vedere se e come l’AI avrà un impatto, positivo o negativo.

Come per qualsiasi altra capacità umana, c’è infatti un largo consenso sul fatto che anche l’intelligenza sia un mix di nature and nurture, ossia di caratteristiche innate del singolo e di altre sviluppate grazie all’esercizio e all’ambiente circostante. È su questo secondo fronte che l’AI potrebbe portare ad una riduzione degli sforzi che ci vengono richiesti, ad esempio, per acquisire e metabolizzare informazioni.

Conclusioni

Quello che sta succedendo con l’AI non è poi tanto diverso dall’innovazione portata nell’ultimo secolo da vari tipi di macchine meccaniche, che hanno ridotto la necessità di fare sforzi (in quel caso fisici, non mentali) per gran parte della popolazione.

Su questo fronte, le macchine ci hanno “richiesto” di adottare delle contromisure: corsa, palestra, sport, diete sono tutti modi per controbilanciare un ridotto sforzo fisico… comunque non sufficienti per tenere sotto controllo una serie di effetti negativi dati dalla maggior sedentarietà della popolazione.

Ora l’AI ci pone la stessa sfida, ma a livello cognitivo. Non sarà scontato adottare l’AI in maniera efficace, integrarla nelle nostre vite personali e professionali, senza però che questa impatti in negativo il nostro senso critico e la nostra intelligenza.

“Più dell'intelligenza artificiale, mi spaventa la stupidità naturale”, ha detto Padre Benanti (e tanti altri prima di lui).

Ho iniziato questo articolo con quattro capolavori, chiudo con un’altra citazione cinematografica: nel 2006 usciva Idiocracy, film comico/satirico di Mike Judge che ipotizza una drastica riduzione dell’intelligenza a 500 anni da oggi3.

Che sia per nature (come suggerisce il film, grottesco ma godibile, a cominciare dalla sua introduzione qui sotto) o nurture (magari a causa di un uso superficiale dell’AI), direi che è una prospettiva che dobbiamo scongiurare!

Gli scambi di accuse, battute, a volte proprio insulti tra i due sono una delle poche costanti nel mondo dell’AI.

Su questo tema, “Nove volte sette” (Feeling of Power) di Asimov è una lettura breve e straodinaria, davvero visionaria se pensate che ha 65 anni.

Articolo e analisi molto interessante e d'ispirazione. L'esempio della moka e della macchina del caffè per la complessità è molto efficace. Concordo in pieno con l'impatto più nel breve termine che l'AI potrebbe avere sulle nostre facoltà mentali che ci contraddistinguono di più: creatività, senso critico, persino il gusto per certi aspetti - se si accettano certi processi automatici per la sintesi di risultati. Per controbilanciare non dobbiamo uscire dal giro ma esprimere ancora di più il nostro essere umani quando interagiamo con queste soluzioni. Ne parlo anche io in un articolo.. 😉

Grandissimo, Alberto. I tuoi articoli sono sempre molto azzeccati. Sto notando molto anch'io questo trend nelle nostre ricerche su responsible AI, AI ethics e AI safety. Raccomando anche di leggere uno studio che fa vedere molto bene il pregiudizio dell'automazione, con radiologi che favoriscono i suggerimenti provenienti da sistemi decisionali automatizzati e ignorano le informazioni contraddittorie (a volte anche le proprie competenze), anche se queste ultime sono corrette: https://pubs.rsna.org/doi/10.1148/radiol.222176#:~:text=In%20conclusion%2C%20we%20show%20that,combining%20human%20readers%20and%20AI